blueMESH auralis

Ein immersives Konzert, das Klang sichtbar macht: Musik verwandelt sich in Echtzeit in Landschaften, Farben und Partikel. Rhythmus wird Bewegung, Melodie wird Raum – ein Erlebnis, das Grenzen zwischen Ton und Bild auflöst und Publikum in eine synästhetische Welt eintauchen lässt.

blueMESH auralis – Musik wird sichtbar

Mit blueMESH auralis entsteht eine immersive Konzertwelt, in der Klang und Bild zu einer synästhetischen Erfahrung verschmelzen. Musik steuert in Echtzeit Landschaften, Farben und Partikel – jeder Ton formt die Umgebung, jeder Rhythmus verändert die Bewegung.

Das Projekt verbindet modernste VR‑Technologie mit künstlerischer Inszenierung:

- Audio‑reaktive Visuals lassen die Energie eines Musikstücks unmittelbar sichtbar werden.

- Filmische Sequenzen verstärken Höhepunkte und schaffen emotionale Übergänge.

- VR & Projection Mode machen das Erlebnis sowohl im Headset als auch als visuelles Bühnenbild zugänglich.

- Live‑Performance ermöglicht Musiker:innen und VJs, die Visuals direkt zu steuern und einzigartige Shows zu kreieren.

blueMESH auralis ist mehr als ein Konzert – es ist ein Raum, in dem Klang zu Bewegung wird und das Publikum Musik nicht nur hört, sondern mit allen Sinnen erlebt.

🔧 Technische Beschreibung – blueMESH auralis

blueMESH auralis ist ein immersives Echtzeit‑System, das Musik in visuelle Räume übersetzt. Die technische Architektur kombiniert leistungsstarke Hardware mit modernster Software, um Klangdaten unmittelbar in interaktive 3D‑Welten zu transformieren.

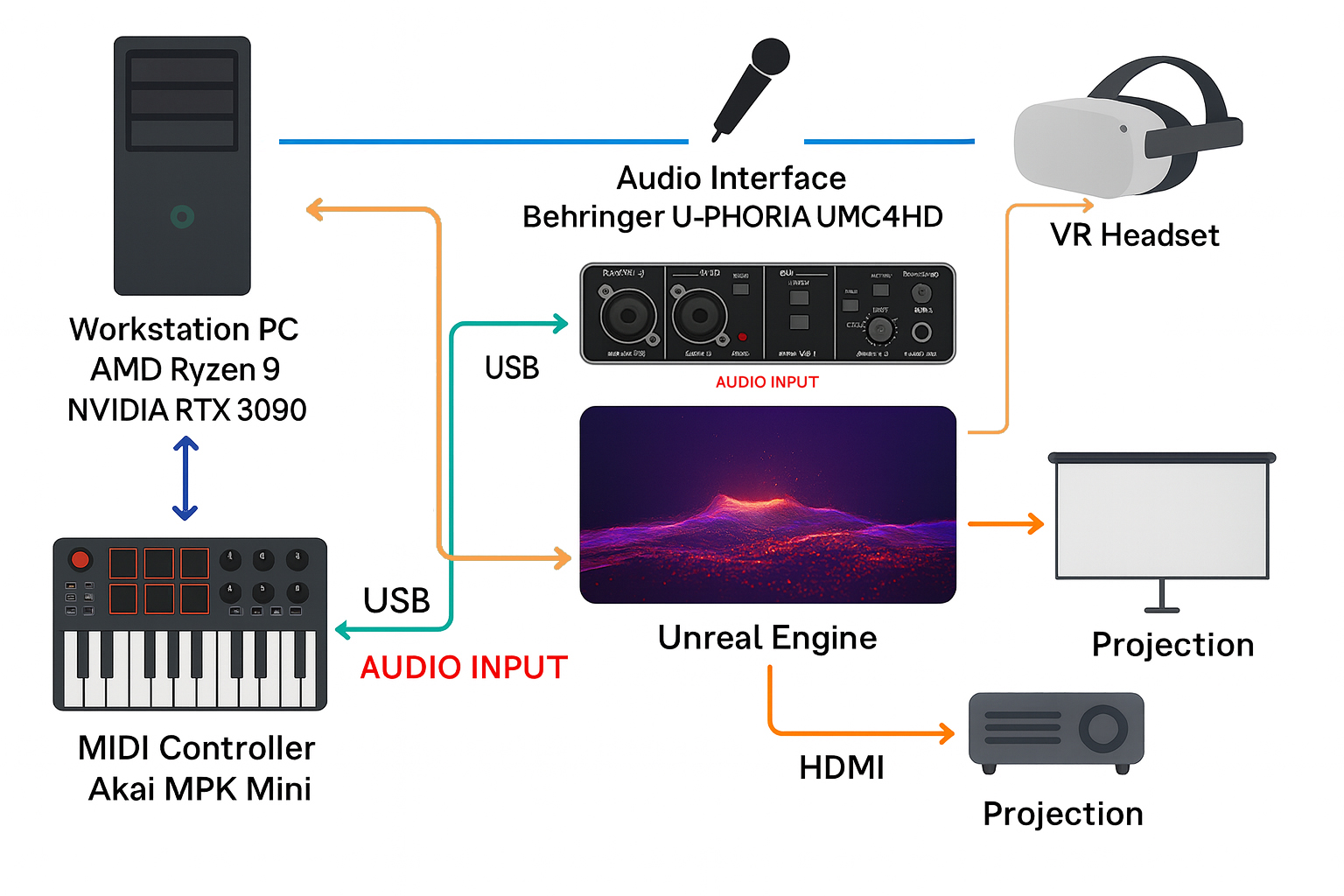

Hardware‑Setup

- Workstation: AMD Ryzen 9 3900X, 64 GB RAM, NVIDIA RTX 3090

- VR‑Headsets: Meta Quest 2 & Meta Quest 3 (Standalone & PC‑VR)

- Audio‑Interface: für sauberes Live‑Routing von Musikquellen

- MIDI‑Controller: zur manuellen Steuerung von Effekten und Parametern

- Laptop (Backup/Streaming): AMD Ryzen 7 5800H, RTX 3070

Software‑Architektur

- Unreal Engine 5.5: zentrale Plattform für Echtzeit‑Rendering, VR‑Integration und Partikelsimulation

- Blender: Asset‑Erstellung, Animation und Shader‑Design

- Audio‑Analyse (FFT): Frequenzspektren werden in Echtzeit berechnet und steuern Shader, Partikel und Materialparameter

- Niagara Partikel‑System: dynamische Visualisierung von Klangenergie

- MIDI‑Mapping: Controller‑Events beeinflussen Farbwechsel, Intensität und Übergänge

Funktionsweise

- Audio‑Input: Musik oder Live‑Instrumente werden über das Audio‑Interface eingespeist.

- FFT‑Analyse: Frequenzbereiche (Bass, Mitten, Höhen) werden mathematisch zerlegt.

- Visual Mapping:

- Bass → Boden pulsiert

- Mitten → Partikelgröße und Dichte

- Höhen → Farbwechsel und Shader‑Effekte

- Interaktive Steuerung: MIDI‑Controller ermöglicht manuelle Eingriffe in Echtzeit.

- VR‑Ausgabe: Die Szene wird auf Quest‑Headsets oder Projektionsflächen dargestellt.

Besonderheiten

- Synästhetische Erfahrung: Musik wird nicht nur hörbar, sondern sichtbar und räumlich erlebbar.

- Live‑Performance‑Modus: Künstler:innen können Visuals wie ein Instrument spielen.

- Bildungs‑ und Kunstintegration: Das System eignet sich für Festivals, Museen und Lernumgebungen.